한눈에 보기: robots.txt 파일은 검색 엔진 크롤러가 접근할 수 있는 영역을 제어하는 핵심 설정입니다. 워드프레스는 기본적으로 robots.txt를 자동 생성하지만, 사이트 규모나 SEO 전략에 따라 수정이 필요합니다. 이 글에서는 안전하면서도 검색 친화적인 robots.txt 최적 설정법을 코드 예시와 함께 소개합니다.

1. robots.txt란? 기본 개념 이해

robots.txt는 웹사이트 루트 디렉토리에 위치한 텍스트 파일로, 검색 엔진 크롤러에게 어떤 페이지를 크롤링할지 알려줍니다. 표준 프로토콜이며, 대부분의 검색 엔진은 이 지침을 존중합니다. 그러나 이는 권장 사항이므로 절대적인 접근 차단 수단이 아님을 이해해야 합니다.

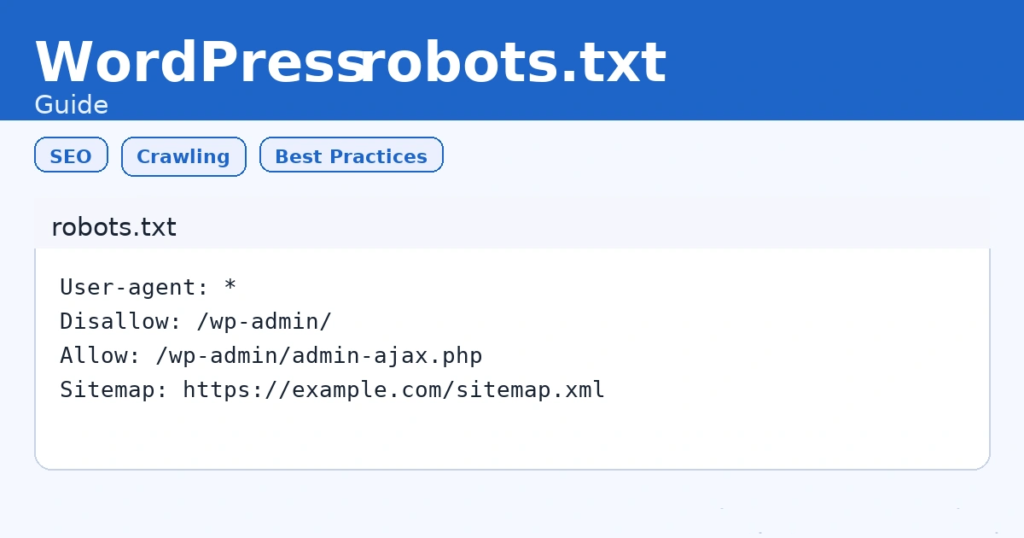

2. 워드프레스의 기본 robots.txt 구조

워드프레스는 물리적인 robots.txt 파일이 없더라도 가상 파일을 자동 제공해줍니다. 기본 내용은 다음과 같습니다.

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php- Disallow: 크롤러가 접근하지 않아야 할 경로 지정

- Allow: 예외적으로 허용할 경로 지정

- User-agent: 명령이 적용될 크롤러 지정, *은 모든 크롤러를 의미

3. SEO 관점에서의 수정 포인트

검색 엔진 최적화를 위해 robots.txt는 최소한으로만 수정하는 것이 좋습니다. 잘못된 설정은 색인 누락으로 이어질 수 있습니다.

- 미디어 파일 차단 금지: 이미지 검색 트래픽을 위해 /wp-content/uploads/는 차단하지 않아야 합니다.

- 플러그인 페이지 차단: 내부 플러그인 경로나 테스트 페이지는 차단 가능

- 사이트맵 경로 추가: 검색 엔진이 사이트 구조를 쉽게 파악하도록 Sitemap 경로를 명시

4. 안전한 크롤링 차단·허용 규칙

불필요한 경로만 선택적으로 차단해 서버 부하를 줄이고, 중요한 페이지는 모두 색인 가능하게 설정해야 합니다.

- 차단 권장 경로:

- /wp-admin/ (관리자 경로)

- /cgi-bin/ (호스팅 기본 폴더)

- /trackback/ (트랙백 페이지)

- 허용 권장 경로:

- /wp-admin/admin-ajax.php

- 업로드 폴더 및 모든 게시물 URL

5. 최적 robots.txt 코드 예시

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://example.com/sitemap.xml이 예시는 기본적인 보안과 색인 효율성을 모두 충족합니다. 사이트맵 경로를 명시해 검색엔진 크롤러가 빠르게 콘텐츠를 색인할 수 있도록 합니다.

6. robots.txt 수정 방법

- 플러그인 활용: All in One SEO, Yoast SEO 등에서 robots.txt 편집 가능

- 물리적 파일 생성: 루트 디렉토리에 robots.txt 파일 생성 후 FTP로 업로드

- 테스트 툴 사용: 구글 서치콘솔·네이버 서치어드바이저에서 오류 검증

7. 사이트맵과 robots.txt 연동

robots.txt에 사이트맵 경로를 추가하면 크롤러가 사이트 구조를 자동으로 파악합니다. 특히 신규 사이트나 빈번한 콘텐츠 업데이트가 있는 사이트는 이 작업이 필수입니다.

- 사이트맵 자동 갱신: All in One SEO, Rank Math 등으로 사이트맵을 자동 생성

- 색인 효율화: 검색 엔진이 최신 콘텐츠를 빠르게 색인

8. FAQ

- robots.txt만으로 페이지 접근을 완전히 막을 수 있나요? 아니요. robots.txt는 크롤러에게 권고하는 파일이므로, 보안 목적에는 적합하지 않습니다.

- robots.txt와 noindex 메타태그 차이는? robots.txt는 크롤링 차단, noindex는 색인 차단으로 성격이 다릅니다.

- 워드프레스 robots.txt는 어디서 수정하나요? SEO 플러그인 내 편집 기능을 사용하거나 루트에 파일을 직접 업로드하면 됩니다.